日本のスーパーコンピュータ「富岳」は、日本語テキストを消化してChatGPTの日本語版を作成する任務を負っている。クレジット: Getty 経由の共同通信社

日本は、ChatGPT の独自バージョンを開発中です。ChatGPT は、アメリカの OpenAI 社が開発した人工知能 (AI) チャットボットで、1 年前のリリース以来世界的な反響を呼びました。

日本政府とNEC、富士通、ソフトバンクなどの大手ハイテク企業は、日本語を使用する大規模言語モデル(LLM)と呼ばれるAIシステムの開発に数億ドルを費やしている。 英語版の翻訳ではなく。

「GBDなどの現在の一般的なLLMは英語では優れていますが、文字構造の違いや限られたデータ、その他の要因により、日本語では不十分なことがよくあります」と、自然言語を専門とする日本の東北大学研究員、坂口圭介氏は言う。 処理。

英語の偏見

LLM は通常、公的に入手可能なソースからの大量のデータを使用して、自然な音声と散文のパターンを学習します。 パッセージ内の前の単語に基づいて次の単語を予測するトレーニングが行われます。 ChatGPT の前のモデルである GPT-3 は、主に英語のテキストでトレーニングされました。

人間のような会話を行う ChatGPT の驚異的な能力は研究者を喜ばせています。 これを省力化ツールの可能性があると見る人もいます。 科学論文やデータの作成に使用されるのではないかと心配する人もいます。

日本では、他言語のデータセットで訓練されたAIシステムが日本の言語や文化のニュアンスを理解できないのではないかという懸念がある。 日本語の文章の構造は英語とは全く異なります。 したがって、ChatGPT は日本語のクエリを英語に翻訳し、応答を見つけて、その応答を日本語に翻訳し直す必要があります。

英語には 26 文字しかありませんが、日本語には 48 の基本的な書き言葉と 2,136 の漢字が 2 つのセットで含まれています。 ほとんどの漢字には 2 つ以上のアクセントがあり、まれに使用される漢字は 50,000 以上あります。 その複雑さを考えると、ChatGPT が言語でつまずくのも不思議ではありません。

日本語では、ChatGPT は「ほとんどの人が見たことのない非常に珍しい文字を作成し、奇妙な未知の単語が生成されることがあります」と坂口氏は言います。

文化的規範

LLM が有用で商業的に実行可能であるためには、文化的慣習と言語を正確に反映している必要があります。 たとえば、ChatGPT が仕事への応募メールを日本語で書くように求められた場合、ChatGPT は標準的な丁寧さの表現をスキップし、英語からの明示的な翻訳を作成します。

LLMが日本文化に対してどれほど敏感であるかを調査するために研究者チームが発足した ラグダ、LLM が日本語のトピックに関する自由形式の質問にどれだけうまく答えることができるかをランキングしたものです。 Raguda の共同創設者 Sam Passaglia と彼の同僚は、静的なプロンプトに対する応答の流動性と文化的関連性を比較するよう ChatGPT に依頼しました。 結果をランク付けするためにツールを使用したところ、6 月に発行されたプレプリントに基づいて GPT-4 が人間の審査員と 87% の確率で一致したことがわかりました。1。 最高のオープンソースの日本の LLM は Raguda で 4 位にランクされていますが、トップ、そしておそらく競争の裁定者でさえあるのは GPT-4 です。

「もちろん、日本のLLMは良くなってきていますが、GPT-4には遠く及ばないのです」と、日本語サンプルを研究している東京大学の物理学者パッサリア氏は言う。 「将来的には GPT-4 と同等かそれを超えることになるでしょう。技術的に克服できないわけではありませんが、リソースの問題です。」と彼は言います。

日本語 LLM を開発するための主要な取り組みでは、世界最速のスーパーコンピュータの 1 つである日本のスーパーコンピュータ「富岳」を使用して、主に日本語入力のトレーニングを行います。 東京工業大学、東北大学、富士通、政府資金援助を受けた理化学研究所の研究センターの支援を受けて、完成したLLMは来年発表される予定だ。 GPT-4 や他の独自モデルとは異なり、他のオープンソース LLM に参加して、そのコードをすべてのユーザーが利用できるようにします。 プロジェクトに携わる坂口氏によると、チームは出力に影響を与え、規模のベンチマークとなる値である少なくとも300億個のパラメータを与えたいと考えているという。

しかし、富岳LLMはさらに大きくなる可能性がある。 日本の文部科学省は、科学的ニーズに沿った日本の AI プログラムの開発を後援しています。このプログラムは、発表された研究から学習して科学的仮説を生成し、調査対象を迅速に特定します。 このモデルは、GPT-3 の半分のサイズである 1,000 億個のパラメーターから開始し、時間の経過とともに拡張できます。

「私たちは、科学研究サイクルを劇的に加速し、研究領域を拡大したいと考えています」とリッケン生命システム動態研究センター副所長の太地誠氏は述べています。 LLMの開発には少なくとも300億円(2億400万米ドル)がかかり、2031年に一般公開される予定だ。

スキルの拡大

他の日本企業も、すでに独自の LLM テクノロジーを商品化しているか、商品化を計画しています。 スーパーコンピュータメーカーのNECは5月に日本語ベースのAIの利用を開始し、内部レポートの作成時間を50%、内部ソフトウェアのソースコードを80%削減したと発表した。 同社は7月に顧客へのカスタマイズ可能なAIサービスの提供を開始した。

「金融、運輸・物流、流通、製造など幅広い業界で利用できる」(NECデータサイエンス研究所の小山田正文主任研究員)という。 研究者は、コードを書いたり、論文の執筆と編集を手伝ったり、既存の論文をレビューしたり、その他の作業を行うことでそれを行うことができると彼は言います。

一方、日本の通信会社ソフトバンクは来年、日本語音声で訓練された生成AIに約200億円を投資して独自のLLMを立ち上げる予定だ。 4,000万人の顧客を抱えるソフトバンクは、企業のビジネスのデジタル化と生産性の向上を支援することを目的として、OpenAIの投資家であるマイクロソフトと提携している。 ソフトバンクは自社のLLMが大学や研究機関などで利用されることを期待している。

一方、日本の研究者らは、正確かつ効果的な日本製のAIチャットボットが科学のスピードを上げ、日本と世界との間の溝を埋めるのに役立つことを期待している。

慶応義塾大学医学部の医療技術研究者である木下正太郎氏は、「SatGBTの日本語版が改良されれば、日本語を学びたい人や日本で研究をしたい人にとって、より良い結果が得られると期待される」と述べた。 東京。 「その結果、国際共同研究に好影響を与える可能性があります。」

「情熱的なコーヒーマニア。ソーシャルメディア愛好家。Twitterの専門家。極端な音楽の専門家。ゾンビ中毒者。ハードコアな旅行のスペシャリスト。」

/cdn.vox-cdn.com/uploads/chorus_asset/file/25592468/2113290621.jpg)

More Stories

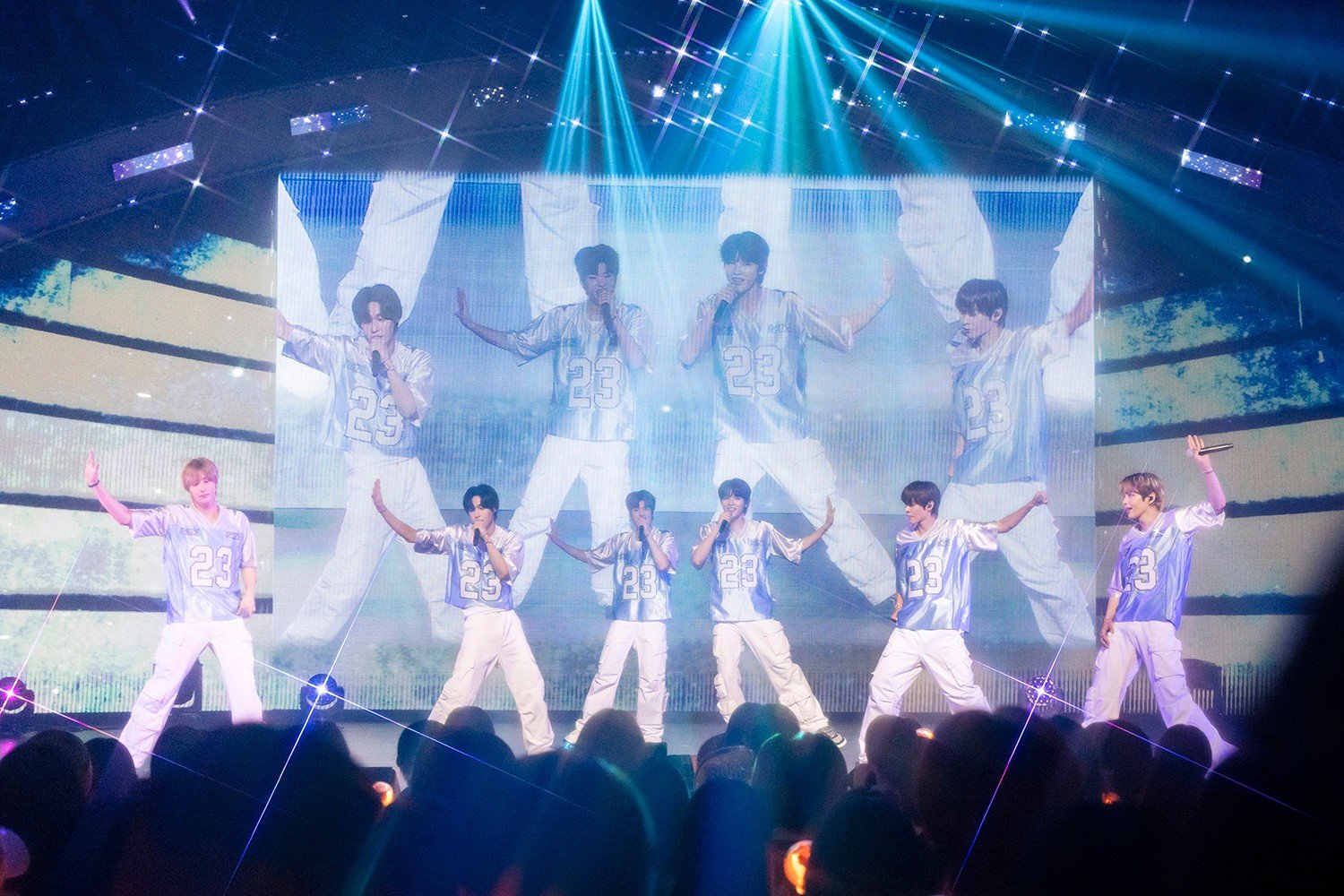

RIIZEの来日公演がソールドアウト

台風シャンシャンが日本に大雨をもたらした後、3人は行方不明となった

日本のパイロット不足により、2030年までに観光客6,000万人の目標が脅かされる |世界のニュース